Title: EgoHumanoid Unlocking In-the-Wild Loco-Manipulation with Robot-Free Egocentric Demonstration

Authors: Modi Shi, Shijia Peng, Jin Chen, Haoran Jiang, Yinghui Li, Di Huang, Ping Luo, Hongyang Li, Li Chen

arXiv: https://arxiv.org/abs/2602.10106

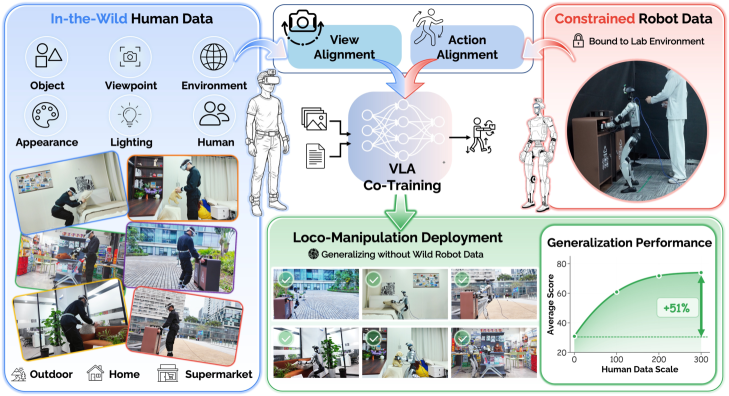

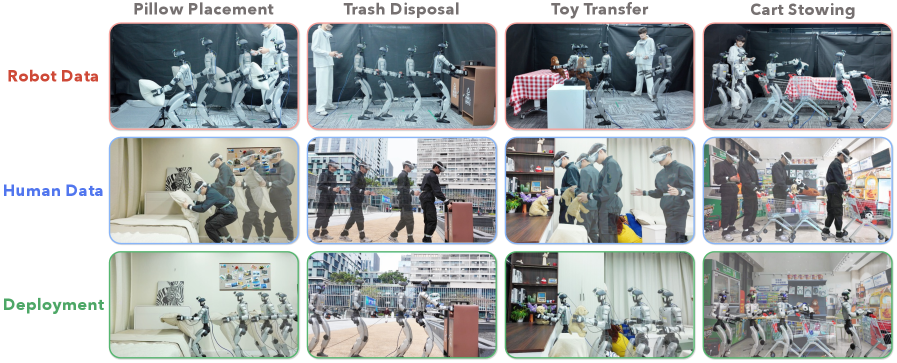

EgoHumanoid试图打破人形数据稀缺的上限:与其昂贵地采集机器人示教,不如利用可规模化的人类第一视角数据。但直接迁移会遇到双重错配——观察视角错配与动作本体错配。论文贡献在于把这两类错配显式拆开并分别约束。

可记为人到机动作映射 ,并要求 ;整体训练目标为

这样模型先把“看见什么”对齐,再把“能做什么”对齐。阅读建议优先看未见环境和跨技能拆分结果,以及去除任一对齐项后的性能塌陷程度。局限在于 egocentric 数据的手物接触细节并不总是充分可见,且人类动作先验并不天然满足机器人动力学约束。

Figures